МОТП, Задачи на экзамене

Материал из eSyr's wiki.

| Строка 5: | Строка 5: | ||

'''Решение:''' | '''Решение:''' | ||

| - | 2. Как метко заметил Оверрайдер, будут задачки на поиск оценки максимального правдоподобия. | + | Рассмотрим следующую задачу: <math>p=5</math>, <math>x_1=(1,1)</math>, <math>x_2=(1,2)</math>, <math>x_3=(3,2)</math>, <math>x_4=(4,1)</math>, <math>x_5=(6,4)</math>. |

| + | |||

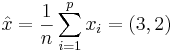

| + | Находим<math> \hat{x}=\frac{1}{n}\sum_{i=1}^px_i=(3,2)</math>. | ||

| + | |||

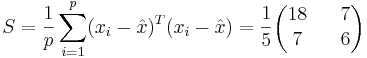

| + | Находим <math> | ||

| + | S=\frac{1}{p}\sum_{i=1}^p(x_i-\hat{x})^T(x_i-\hat{x})= | ||

| + | \frac{1}{5}\begin{pmatrix}18 && 7 \\ 7 && 6 \end{pmatrix} | ||

| + | </math> | ||

| + | |||

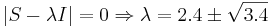

| + | Решаем <math>|S-\lambda I| = 0 \Rightarrow \lambda=2.4\pm \sqrt{3.4}</math> | ||

| + | |||

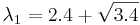

| + | Находим собственный вектор, соответствующий <math>\lambda_1=2.4+\sqrt{3.4}</math>, решая <math>(S-\lambda_1I)\hat{d}=0</math>. Получаем <math>\hat{d}=(0.9085, 0.4179)</math> - собственный вектор, соответствующий максимальному собственному значению матрицы ковариации. Он и будет являться первой главной компонентой. | ||

| + | |||

| + | Подробные вычисления не приведены. Можете сами повторить и сверить результаты. Однако сильно не надейтесь найти ошибку, решение проверено в MATLAB. | ||

| + | |||

| + | |||

| + | 2. Как метко заметил Оверрайдер, будут задачки на поиск оценки максимального правдоподобия. Не сложные, но чтобы было интереснее, не с нормальным распределением. Что-нибудь типа найти оценку МП на параметр распределения Лапласа. | ||

'''Решение:''' | '''Решение:''' | ||

| Строка 27: | Строка 43: | ||

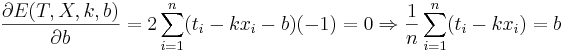

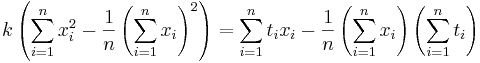

<math>k \left(\sum_{i=1}^nx_i^2-\frac{1}{n}\left(\sum_{i=1}^nx_i\right)^2\right)=\sum_{i=1}^nt_ix_i-\frac{1}{n}\left(\sum_{i=1}^nx_i\right)\left(\sum_{i=1}^nt_i\right)</math> | <math>k \left(\sum_{i=1}^nx_i^2-\frac{1}{n}\left(\sum_{i=1}^nx_i\right)^2\right)=\sum_{i=1}^nt_ix_i-\frac{1}{n}\left(\sum_{i=1}^nx_i\right)\left(\sum_{i=1}^nt_i\right)</math> | ||

| - | Подставляем значения для <math>x_i</math> и <math>t_i</math>, получаем <math>k</math>, затем <math>b</math>. | + | Подставляем значения для <math>x_i</math> и <math>t_i</math>, получаем <math>k</math>, затем <math>b</math>. Решение проверено на нескольких наборах данных в MATLAB. |

| + | |||

| + | Еще один вариант - посчитать напрямую <math>(k,b)=(X^TX)^{-1}X^TY</math>, где <math>X</math> - матрица, первый столбец которой составлен из <math>x_i</math>, второй - из единиц, а <math>Y</math> - столбец из <math>t_i</math>. | ||

Версия 23:15, 25 мая 2009

За нерешение данных задач оценка снижается на балл.

1. Даны р точек в двухмерном пространстве (буду прямо их ручкой у вас на листочке задавать). Найти методом главных компонент первую главную компоненту. Так что вспоминайте как матрицу 2х2 к главным осям приводить и ковариации считать.

Решение:

Рассмотрим следующую задачу: p = 5, x1 = (1,1), x2 = (1,2), x3 = (3,2), x4 = (4,1), x5 = (6,4).

Находим .

.

Находим

Решаем

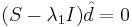

Находим собственный вектор, соответствующий  , решая

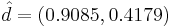

, решая  . Получаем

. Получаем  - собственный вектор, соответствующий максимальному собственному значению матрицы ковариации. Он и будет являться первой главной компонентой.

- собственный вектор, соответствующий максимальному собственному значению матрицы ковариации. Он и будет являться первой главной компонентой.

Подробные вычисления не приведены. Можете сами повторить и сверить результаты. Однако сильно не надейтесь найти ошибку, решение проверено в MATLAB.

2. Как метко заметил Оверрайдер, будут задачки на поиск оценки максимального правдоподобия. Не сложные, но чтобы было интереснее, не с нормальным распределением. Что-нибудь типа найти оценку МП на параметр распределения Лапласа.

Решение:

3. Обязательно кому-то дам задачку на условную максимизацию квадратичной функции с линейным ограничением в виде равенства. Писанины там немного, но вот без правила множителей Лагранжа обойтись вряд ли удастся.

Решение:

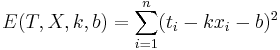

4. Даны 3-4 точки в двухмерном пространстве - одна координата, это х, другая - t. Задача построить по ним линейную регрессию вида  , т.е. найти коэффициенты k и b.

, т.е. найти коэффициенты k и b.

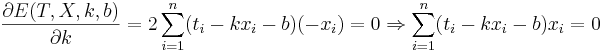

Решение:

Подставляем значения для xi и ti, получаем k, затем b. Решение проверено на нескольких наборах данных в MATLAB.

Еще один вариант - посчитать напрямую (k,b) = (XTX) − 1XTY, где X - матрица, первый столбец которой составлен из xi, второй - из единиц, а Y - столбец из ti.